大数据技术原理与应用实验1熟悉常用的Linux操作和Hadoop操作

实验1 熟悉常用的Linux操作和Hadoop操作

1.实验目的

Hadoop运行在Linux系统上,因此,需要学习实践一些常用的Linux命令。本实验旨在熟悉常用的Linux操作和Hadoop操作,为顺利开展后续其他实验奠定基础。

2.实验平台

(1)操作系统: Ubuntu-22.04.2-desktop-amd64

(2)Hadoop版本:3.1.3

3.实验步骤与结果

*1.熟悉常用的Linux*操作

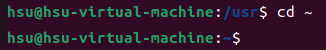

1)cd命令:切换目录

(1) 切换到目录“/usr/local”

(2) 切换到当前目录的上一级目录

(3) 切换到当前登录Linux系统的用户的自己的主文件夹

2)ls命令:查看文件与目录

查看目录“/usr”下的所有文件和目录

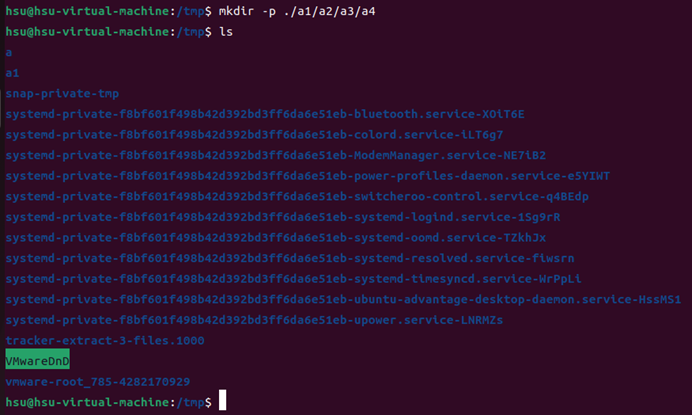

3)mkdir命令:新建目录

(1)进入“/tmp”目录,创建一个名为“a”的目录,并查看“/tmp”目录下已经存在哪些目录

(2)进入“/tmp”目录,创建目录“a1/a2/a3/a4”

4)rmdir命令:删除空的目录

(1)将上面创建的目录a(在“/tmp”目录下面)删除

(2)删除上面创建的目录“a1/a2/a3/a4” (在“/tmp”目录下面),然后查看“/tmp”目录下面存在哪些目录

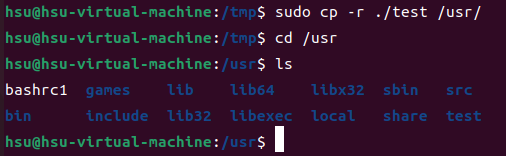

5)cp命令:复制文件或目录

(1)将当前用户的主文件夹下的文件.bashrc复制到目录“/usr”下,并重命名为bashrc1

(2)在目录“/tmp”下新建目录test,再把这个目录复制到“/usr”目录下

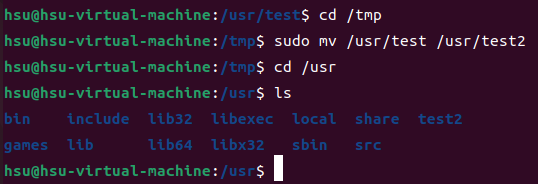

6)mv命令:移动文件与目录,或更名

(1)将“/usr”目录下的文件bashrc1移动到“/usr/test”目录下

(2)将“/usr”目录下的test目录重命名为test2

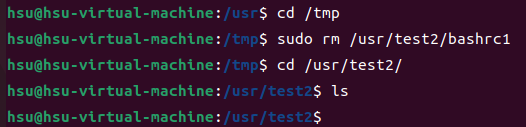

7)rm命令:移除文件或目录

(1)将“/usr/test2”目录下的bashrc1文件删除

(2)将“/usr”目录下的test2目录删除

8)cat命令:查看文件内容

查看当前用户主文件夹下的.bashrc文件内容

9)tac命令:反向查看文件内容

反向查看当前用户主文件夹下的.bashrc文件的内容

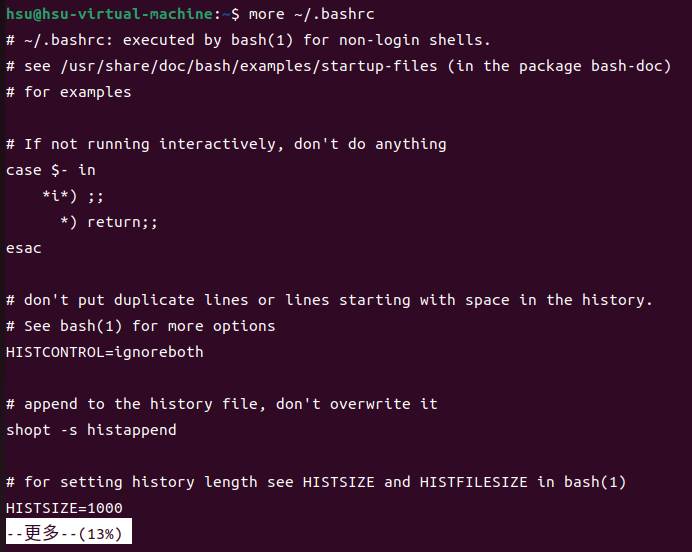

10)more命令:一页一页翻动查看

翻页查看当前用户主文件夹下的.bashrc文件的内容

11)head命令:取出前面几行

(1)查看当前用户主文件夹下.bashrc文件内容前20行

(2)查看当前用户主文件夹下.bashrc文件内容,后面50行不显示,只显示前面几行

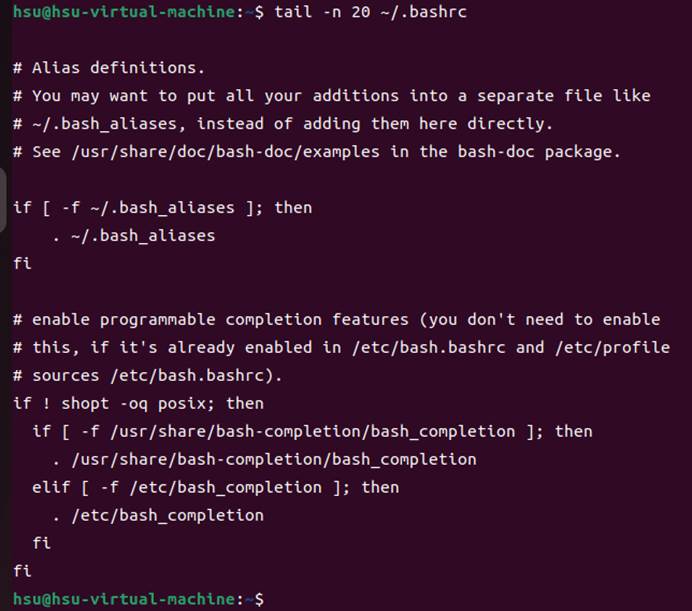

12)tail命令:取出后面几行

(1)查看当前用户主文件夹下.bashrc文件内容最后20行

(2)查看当前用户主文件夹下.bashrc文件内容,并且只列出50行以后的数据

13)touch命令:修改文件时间或创建新文件

(1)在“/tmp”目录下创建一个空文件hello,并查看文件时间

(2)修改hello文件,将文件时间整为5天前

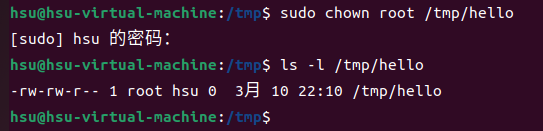

14)chown命令:修改文件所有者权限

将hello文件所有者改为root帐号,并查看属性

15)find命令:文件查找

找出主文件夹下文件名为.bashrc的文件

16)tar命令:压缩命令

(1)在根目录“/”下新建文件夹test,然后在根目录“/”下打包成test.tar.gz

(2)把上面的test.tar.gz压缩包,解压缩到“/tmp”目录

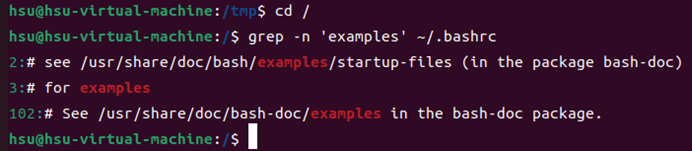

17)grep命令:查找字符串

从“~/.bashrc”文件中查找字符串’examples’

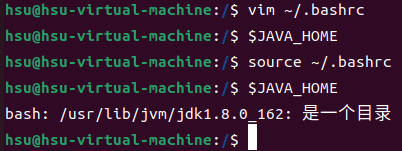

18)配置环境变量

(1)请在“~/.bashrc”中设置,配置Java环境变量

(2)查看JAVA_HOME变量的值

*2.熟悉常用的Hadoop*操作

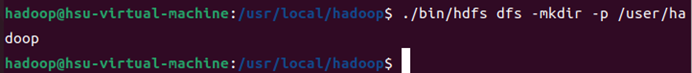

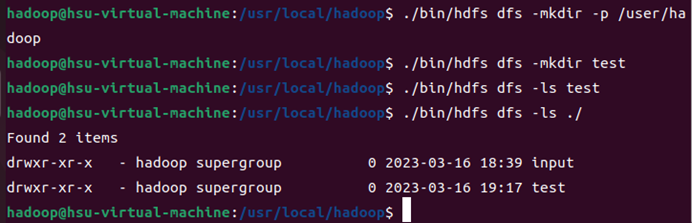

(1)使用hadoop用户登录Linux系统,启动Hadoop(Hadoop的安装目录为“/usr/local/hadoop”),为hadoop用户在HDFS中创建用户目录“/user/hadoop”

(2)接着在HDFS的目录“/user/hadoop”下,创建test文件夹,并查看文件列表

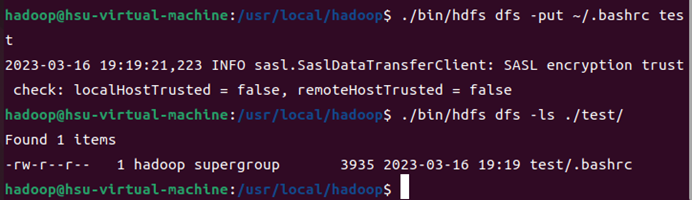

(3)将Linux系统本地的“~/.bashrc”文件上传到HDFS的test文件夹中,并查看test

(4) 将HDFS文件夹test复制到Linux系统本地文件系统的“/usr/local/hadoop”目录下

4.实验总结

(1)实验完成情况

实验完成率:100%

(2)出现的问题与解决方案

问题1:在安装虚拟机的时候遇到了版本界面和教程不适配,以及hadoop下载出错的问题。

问题2:使用虚拟机进行实验的时候出现VMware Workstation 17 频繁未响应的问题。

解决:我通过百度解决了问题,最后决定关闭qq,将qq快捷截图改成windows自带的shift+win+s的截图方式。同时采用快捷键ctrl+alt来将鼠标从虚拟机中切换到主电脑上,避免不必要的未响应问题。

这里给出链接http://www.huwoo.net/2020/post-4036.html

问题3:虚拟机与我的电脑之间文件的交换

解决: 采用SecureCRT 8.0软件。

输入虚拟机的ip地址,然后依次填入hadoop账户的用户名和密码

最后在这个界面上

可以直接将左侧的文件拖动到右侧界面里面即可实现将我的电脑的文件上传到虚拟机里面。